Jak modele LLM zmieniają wyszukiwanie?

• Co odróżnia AI Search od klasycznych wyszukiwarek?

• Jak działają LLM?

• Dlaczego użytkownicy zmieniają sposób, w jaki googlują?

• Podsumowanie

• FAQ - pytania i odpowiedzi

AI Search zamienia wyszukiwanie w rozmowę, która rozumie intencję, streszcza najważniejsze wnioski i od razu podaje źródła. W tym rozdziale przewodnika pokazujemy, co dzieje się „pod maską” LLM-ów, skąd biorą się ich mocne strony i potknięcia, oraz jak zmieniają się zachowania użytkowników względem procesu wyszukiwania.

Z tego rozdziału dowiesz się:

- Czym AI Search różni się od klasycznego wyszukiwania,

- Jak działają modele LLM,

- Czym jest technologia transformerów,

- Jakie są ograniczenia działania GPT,

- Jak zmieniają się zachowania użytkowników w wyszukiwaniu.

Co odróżnia AI Search od klasycznych wyszukiwarek?

Wyszukiwarki AI (Artificial Intelligence) Search różnią się celem i wynikiem, mechaniką działania i podejściem do wiedzy, odróżnia je od Google także ryzyko działania i kwestia wiarygodności. Przyjrzyjmy się kolejno każdemu z nich.

Różnice w celu i wyniku

Choć z pozoru i Google i ChatGPT odpowiadają na pytania, w praktyce robią to w zupełnie inny sposób. Klasyczne wyszukiwarki, jak Google, zostały zbudowane wokół idei listy linków - tzw. SERP (Search Engine Results Page). Ich zadaniem jest wskazanie, gdzie znajduje się odpowiedź, a nie udzielenie jej bezpośrednio. Google analizuje miliardy stron, ocenia ich autorytet, doświadczenie i wiarygodność według zasad E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) i na tej podstawie tworzy ranking.

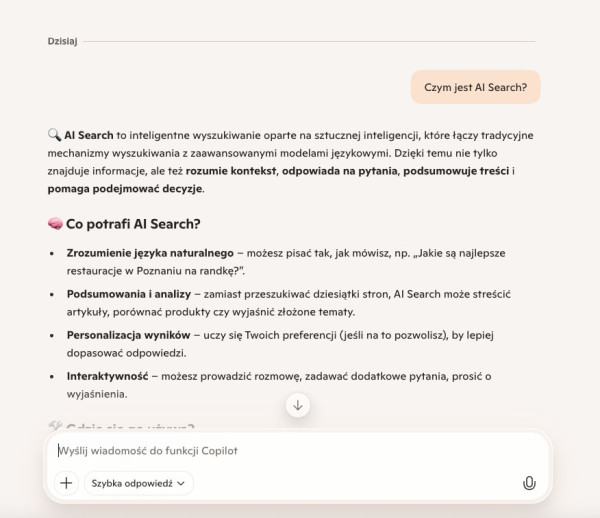

W przeciwieństwie do tego, AI Search (czyli systemy takie jak ChatGPT, Perplexity AI czy Microsoft Copilot) nie wyszukują stron, lecz generują odpowiedzi. Zamiast linków otrzymujemy podsumowanie lub pełną wypowiedź w języku naturalnym. Modele AI nie chcą być katalogiem: chcą być partnerem w rozmowie, kimś, kto rozumie intencję i potrafi ją rozwijać.

Przykładowa odpowiedź w narzędziu Microsoft Copilot.

Co więcej, te nowe systemy dostosowują ton i styl do kontekstu pytania. Perplexity cytuje źródła niczym skrupulatnie, ChatGPT rozmawia naturalnie, a Copilot integruje wiedzę z dokumentów Microsoft 365, podając ją w uporządkowanej, biurowej formie. Klasyczne wyszukiwanie pokazuje drogę, a AI Search ją rozszerza.

Czytaj również:

Podstawowa mechanika działania i kwestia wiedzy

Tu zaczyna się prawdziwy paradoks. Choć ChatGPT, Claude czy Gemini sprawiają wrażenie wiedzących, w rzeczywistości nie posiadają żadnej wiedzy w klasycznym sensie. Nie mają baz danych ani świadomości. Działają poprzez statystyczne przewidywanie kolejnych słów: analizują kontekst i wyliczają, które słowo prawdopodobnie powinno pojawić się następne. To oznacza, że gdy zapytasz ChatGPT o historię Internetu, model nie wie tego tak jak człowiek. On po prostu przewiduje - opierając się na miliardach wzorców z danych, na których był trenowany.

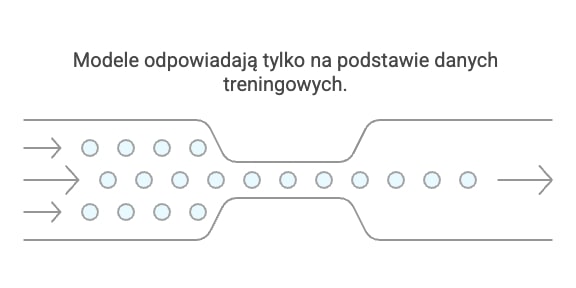

Kolejnym ograniczeniem jest brak bezpośredniego dostępu do internetu. Klasyczne modele LLM (Large Language Models) nie przeszukują sieci w czasie rzeczywistym. Odpowiadają wyłącznie na podstawie informacji, które widziały podczas treningu. Dopiero nowsze integracje, jak ChatGPT z włączonym trybem „Browse” czy Perplexity z funkcją „Pro Search”, pozwalają im łączyć się z siecią, ale nawet wtedy nie działa to tak jak w Google. One nie indeksują stron, tylko pobierają fragmenty treści, które wydają się istotne.

Ta mechanika generowania niesie też ze sobą dobrze znane zjawisko: halucynacje. Modele potrafią tworzyć przekonująco brzmiące, ale zupełnie fikcyjne dane, cytaty i URL-e. Dzieje się tak dlatego, że dla nich adres strony to po prostu sekwencja liter i cyfr, która pasuje do kontekstu. Nie ma różnicy między prawdziwym linkiem a wymyślonym, bo oba są statystycznie prawdopodobne.

W praktyce oznacza to, że nawet najbardziej zaawansowany chatbot potrafi wymyślić recenzję z nieistniejącego czasopisma, jeśli taka konstrukcja „pasuje” do wzorca językowego.

Jak modele LLM wykorzystują dane treningowe.

Czytaj również:

Ryzyko i wiarygodność

Największym problemem nie jest to, że modele czasem się mylą, ale że użytkownicy traktują je jak nieomylne. Zjawisko antropomorfizacji - przypisywania AI cech ludzkich - sprawia, że rozmowa z chatbotem wydaje się bardziej wiarygodna niż suchy wynik wyszukiwania. Kiedy ChatGPT mówi „na podstawie badań wynika…”, wielu ludzi automatycznie przyjmuje to jako fakt. Tymczasem to tylko ciąg słów o wysokim prawdopodobieństwie wystąpienia obok siebie.

Ta złudna pewność bywa szczególnie niebezpieczna w obszarach AI Search takich jak YMYL (Your Money, Your Life), czyli wszędzie tam, gdzie błędna informacja może mieć realne konsekwencje: zdrowotne, finansowe, prawne. Model może z pełnym przekonaniem napisać, że „żonkile są jadalne”, bo w danych pojawiła się błędna korelacja między słowami „kwiat” i „jadalny”. Taka pomyłka, choć z perspektywy AI drobna, w rzeczywistości może skończyć się tragicznie. Sprawdź więcej informacji o YMYL i innych wytycznych dla webmasterów.

Do tego dochodzi kwestia stronniczości danych. Modele uczą się na ogromnych zbiorach tekstów z internetu - a te, jak wiadomo, pełne są błędów, uprzedzeń i tendencyjnych opinii. W efekcie AI potrafi nieświadomie reprodukować stereotypy: faworyzować określone grupy, wykluczać inne lub wzmacniać istniejące nierówności. W pamięci branży wciąż żyje przykład Amazona, którego rekrutacyjny system AI dyskryminował kobiety, bo nauczył się, że w danych historycznych większość zatrudnianych to mężczyźni.

To pokazuje, że każdy model wymaga kosztownego procesu fine-tuningu, czyli ręcznego dostrajania, aby minimalizować błędy i uprzedzenia. Jednak nawet najlepiej wytrenowana AI nie jest neutralna. Jej perspektywa zawsze odzwierciedla dane, na których powstała.

Z tego powodu coraz częściej mówi się o konieczności weryfikacji krzyżowych odpowiedzi generowanych przez AI. To oznacza, że użytkownik nie powinien ufać jednemu modelowi, ale raczej sprawdzać, czy ChatGPT, Perplexity i Copilot zgadzają się w danej kwestii. Czytaj więcej o generatywnej AI.

Wyniki tego samego zapytania w Microsoft Copilot, ChatGPT i Perplexity.

Jak działają LLM?

LLM-y coraz częściej są pierwszym wyborem użytkowników w przypadku konieczności wyszukiwania informacji - to AI Search. LLM-y to modele językowe w dużej skali, które działają dzięki odpowiednim treningom i technologii transformerów. Mają też swoje ograniczenia, takie jak zjawisko halucynacji.

Jaki jest mechanizm działania LLM i na czym są trenowane?

Modele językowe dużej skali to potężne sieci neuronowe zbudowane z miliardów, a czasem nawet bilionów parametrów. Każdy z tych parametrów działa jak maleńka waga ucząca się, które słowa czy frazy są ze sobą powiązane. Im większy model, tym lepiej potrafi uogólniać wiedzę, wychwytywać kontekst i rozumieć subtelności języka.

Trening takiego modelu przypomina uczenie dziecka, które przeczytało cały internet. Dane pochodzą z Wikipedii, forów, blogów, artykułów naukowych, a nawet komentarzy na Redditcie. To ogromna masa tekstu, w której LLM uczy się wzorców, relacji między słowami i znaczeń w różnych kontekstach. Nie rozumie ich tak jak człowiek, ale rozpoznaje schematy i zależności z matematyczną precyzją.

W świecie naukowym używa się nawet ironicznego określenia „stochastic parrots”, czyli „statystyczne papugi”. To trafne porównanie: LLM nie tworzy wiedzy, tylko powtarza i komponuje na nowo to, co „słyszał” w danych treningowych. Działa jak niezwykle inteligentna papuga, która potrafi mówić sensownie, ale nie ma świadomości, co naprawdę mówi.

Ta natura statystycznego przewidywania sprawia, że LLM potrafią zaskakująco dobrze tworzyć spójne, przekonujące teksty: od esejów i scenariuszy po raporty i analizy. Ale równocześnie oznacza, że ich wiedza kończy się na dacie ostatniego treningu, a odpowiedzi są probabilistyczne, nie faktograficzne.

Czym jest technologia transformerów i mechanizm uwagi?

Prawdziwa rewolucja w przetwarzaniu języka w AI Search zaczęła się w 2017 roku, gdy zespół z Google Brain opublikował artykuł „Attention is All You Need”. To właśnie tam po raz pierwszy opisano architekturę transformerów - technologię, która dziś napędza niemal wszystkie nowoczesne modele językowe, od GPT po Gemini.

Wcześniej modele oparte na RNN (Rekurencyjnych Sieciach Neuronowych) przetwarzały tekst krok po kroku, słowo po słowie. To przypominało czytanie linijka po linijce bez możliwości cofnięcia się. Problem polegał na tym, że im dłuższy był tekst, tym trudniej modelowi było zapamiętać kontekst sprzed kilku zdań.

Transformery całkowicie odwróciły tę logikę. Dzięki mechanizmowi uwagi (self-attention) model może analizować wszystkie słowa jednocześnie, a nie po kolei. Wyobraź sobie, że czytasz zdanie: „Pies, który gonił kota, był biały”. Klasyczny RNN mógłby zgubić, do kogo odnosi się „biały”. Transformer natomiast rozumie, że słowo „biały” opisuje „psa”, bo potrafi ważyć znaczenie każdego słowa względem pozostałych.

Mechanizm uwagi oblicza tzw. attention scores - liczby określające, jak bardzo każde słowo wpływa na sens zdania. Dzięki temu model potrafi zauważać relacje między odległymi fragmentami tekstu i tworzyć bardziej logiczne, spójne wypowiedzi. To właśnie dlatego GPT czy Claude potrafią pisać eseje, streszczać książki czy analizować długie raporty - coś, co dla wcześniejszych sieci było praktycznie niemożliwe.

Co ważne, transformery działają równolegle: analizują tysiące tokenów jednocześnie, co czyni je znacznie szybszymi i bardziej skalowalnymi. To z kolei otworzyło drogę do trenowania modeli o gigantycznych rozmiarach, z miliardami połączeń, które dziś rozumiemy jako LLM.

Zastosowanie GPT i jego ograniczenia

Najbardziej znanym przykładem wykorzystania architektury transformerów jest GPT - Generative Pre-trained Transformer. Jak sama nazwa wskazuje, model najpierw przechodzi pre-training (uczenie na ogólnych danych), a potem można go dostroić do konkretnych zadań, np. pisania kodu, tłumaczenia czy generowania artykułów.

Proces działania GPT jest intuicyjny: dostaje prompt, czyli instrukcję, i przewiduje, jakie słowa powinny pojawić się dalej. Działa to trochę jak bardzo zaawansowane uzupełnianie tekstu - przewidywanie kolejnego wyrazu na podstawie kontekstu. W efekcie powstają wypowiedzi, które brzmią naturalnie, a czasem nawet błyskotliwie.

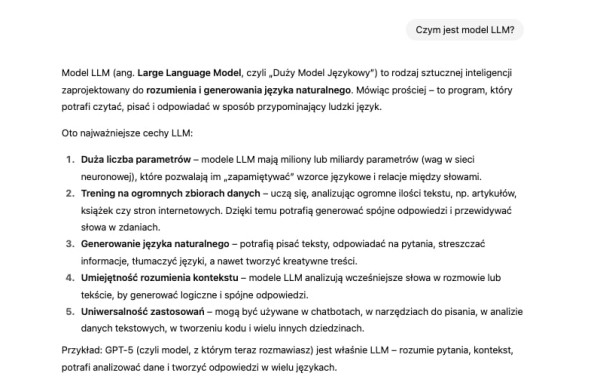

LLM doskonale sprawdzają się w zadaniach ogólnych, takich jak:

- Analiza sentymentu (np. ocena emocji w opiniach użytkowników),

- Przekształcanie tekstu w dane strukturalne (np. JSON, XML),

- Streszczanie i parafrazowanie treści,

- Kreatywne generowanie pomysłów - od nazw marek po scenariusze reklamowe.

Zadania, w których dobrze sprawdzają się LLM.

Tam, gdzie potrzebna jest elastyczność i kontekst, modele się wyróżniają. Ale gdy chodzi o precyzję matematyczną czy logiczne rozumowanie, ich wyniki bywają niestabilne. Dzieje się tak dlatego, że GPT nie analizuje faktów, on przewiduje, jakie zdanie powinno pasować.

W efekcie LLM potrafią tworzyć bardzo przekonujące, lecz nie zawsze prawdziwe odpowiedzi. W zadaniach, w których liczy się dokładność (np. ekstrakcja słów kluczowych, analiza danych liczbowych), klasyczne algorytmy (takie jak TF-IDF czy modele regresyjne) wciąż bywają lepsze. GPT potrafi stworzyć zgrabne streszczenie raportu, ale niekoniecznie wskaże, które dane są naprawdę istotne.

Kolejnym ograniczeniem jest halucynacja semantyczna: zjawisko, w którym model generuje logicznie spójną, lecz nieprawdziwą informację. LLM nie potrafi odróżnić prawdy od fikcji, ponieważ nie wie, czym jest prawda. Wie tylko, że dane słowo często występuje obok innego. Mimo to, ich wszechstronność sprawia, że LLM stały się podstawą nowej generacji wyszukiwarek. To one napędzają AI Search: ChatGPT, Perplexity AI, Claude, Copilota i Gemini. W odróżnieniu od klasycznych systemów nie przeszukują one internetu w czasie rzeczywistym, lecz generują wiedzę w formie rozmowy, łącząc ludzką ekspresję z matematycznym modelem języka.

To właśnie dzięki tej fuzji technicznej elegancji i lingwistycznego realizmu wyszukiwanie przestaje być czynnością, a staje się doświadczeniem: nie szukasz informacji, tylko rozmawiasz z nią.

Czytaj również:

Dlaczego użytkownicy zmieniają sposób, w jaki googlują?

Zmieniło się wiele aspektów tego, jak użytkownicy obecnie wyszukują informacje. Zmieniły się oczekiwania użytkowników, którzy chcą od razu otrzymać informację i nie chcą długiego procesu poszukiwań. Użytkownicy w inny sposób wchodzą w interakcję z wyszukiwarkami: obecnie coraz częściej jest to wyszukiwanie głosowe lub wyszukiwanie obrazem. Użytkownicy szukają też informacji na wielu różnych kanałach.

Zmiana oczekiwań użytkowników

Wraz z rozwojem wyszukiwarek opartych na AI zmieniają się nie tylko technologie, ale i ludzkie nawyki. Użytkownicy nie chcą już szukać - chcą natychmiast wiedzieć. Coraz częściej oczekują, że odpowiedź pojawi się od razu, w formie streszczenia, rekomendacji lub konkretnego rozwiązania. Nie interesuje ich lista stron, tylko wynik dopasowany do ich kontekstu: miejsca, historii wyszukiwań, a nawet nastroju.

To przesunięcie w kierunku personalizacji i natychmiastowości jest widoczne na każdym kroku. Perplexity, ChatGPT i Copilot dostosowują ton, długość i format odpowiedzi do użytkownika, czasem pisząc formalnie, czasem jak znajomy tłumaczący coś przy kawie. Użytkownik nie chce przeszukiwać, chce od razu rozumieć.

Jednocześnie kluczowa staje się zasada „above the fold”: informacja musi być widoczna natychmiast, bez przewijania i klikania w dziesiątki linków. To pokłosie mediów społecznościowych, gdzie każda sekunda decyduje o utrzymaniu uwagi użytkownika. Jeśli wyszukiwarka nie poda odpowiedzi w pierwszym zdaniu, użytkownik przejdzie do innej platformy.

Przykład mechanizmu above the fold.

Dlatego AI Search musi działać proaktywnie. Dzisiejsze wyszukiwarki coraz częściej przewidują potrzeby użytkownika, zanim ten je wypowie. Jeśli ktoś regularnie szuka przepisów, system zaproponuje kolejne danie. Jeśli analizuje dane finansowe, zasugeruje raport. To subtelna, ale znacząca zmiana: wyszukiwanie nie zaczyna się już od pytania, lecz od kontekstu.

Dzięki sztucznej inteligencji czas spędzony na formułowaniu zapytań znacząco się skrócił. Ludzie zadają mniej pytań, ale dostają więcej odpowiedzi, dokładniejszych i dopasowanych.

Ewolucja metod interakcji

Jeszcze niedawno wpisywaliśmy w Google hasła w stylu: „tanie loty Mediolan 2025”. Dziś pytamy: „Gdzie warto polecieć w maju, jeśli lubię architekturę i kawę?”, i oczekujemy, że wyszukiwarka zrozumie, że chodzi o emocje, styl życia i budżet.

Ta zmiana to efekt dialogowego podejścia do wyszukiwania. Użytkownicy zaczęli rozmawiać z wyszukiwarkami, a nie tylko ich używać. ChatGPT, Claude i Copilot pozwoliły na coś, czego wcześniej brakowało - ciągłość kontekstu. Nie musimy zaczynać od zera, możemy doprecyzować, dopytać, zmienić ton rozmowy. To doświadczenie bardziej przypomina konsultację niż klasyczne wyszukiwanie.

Równolegle rozwinęło się wyszukiwanie głosowe w AI Search. Dla młodszych użytkowników, przyzwyczajonych do rozmowy z telefonem, to już naturalny sposób interakcji. W 2025 roku niemal połowa zapytań mobilnych w Stanach Zjednoczonych odbywa się głosowo. Zamiast pisać, po prostu pytamy: „Hej, które sneakersy są teraz modne?” lub „Kiedy otwiera się to nowe muzeum w Barcelonie?”.

Wyszukiwanie wizualne poszło jeszcze dalej. Narzędzia takie jak Google Lens przetwarzają już ponad 10 miliardów wyszukiwań miesięcznie, a funkcja „Circle to Search” pozwala dosłownie narysować zapytanie: otoczyć obraz palcem i poprosić AI o jego interpretację. Szukamy więc nie słów, a znaczeń. Robimy zdjęcie rośliny i pytamy, co to jest. Zeskanujemy fragment tekstu i prosimy o streszczenie. To pokazuje, że sposób komunikacji z wyszukiwarkami ewoluuje z języka pisma do języka doświadczeń: mówimy, pokazujemy, gestykulujemy, a AI rozumie.

Dynamika wielu platform

Jeszcze kilka lat temu Google był punktem startowym dla większości wyszukiwań. Dziś jest tylko jednym z przystanków. Użytkownicy korzystają średnio z sześciu lub więcej kanałów, by znaleźć odpowiedź: od TikToka i Reddita po Perplexity, ChatGPT i LinkedIna. Szukamy tam, gdzie czujemy się komfortowo, tam, gdzie ktoś mówi naszym językiem.

To zjawisko określa się jako „multi-platform search behavior” - zachowanie wielokanałowe. Typowa ścieżka użytkownika wygląda dziś tak: ktoś widzi nowy produkt na Instagramie, czyta recenzję w Google, a następnie pyta ChatGPT, czy warto go kupić. W międzyczasie może sprawdzić ceny w Copilocie i obejrzeć tutorial na YouTube. To nie chaos - to nowy, naturalny rytm wyszukiwania.

Przykładowa ścieżka użytkownika.

Dla marek i twórców oznacza to jedno: informacja musi być spójna na wszystkich poziomach. Nie wystarczy być widocznym w Google, aby odnieść sukces w AI Search. Trzeba istnieć tam, gdzie użytkownik prowadzi rozmowę: w czacie, w komentarzu, w krótkim filmie. To, co kiedyś było prostym lejkiem marketingowym (Google → strona → konwersja), teraz przypomina sieć połączeń. Użytkownik może rozpocząć poszukiwania na Instagramie, przejść do artykułu eksperckiego, potem do wyszukiwarki AI, a ostatecznie wrócić na TikToka po opinię znajomego twórcy.

Ta płynność nie jest przypadkiem. To efekt rosnącej elastyczności narzędzi AI, które coraz lepiej współpracują z innymi platformami. Copilot integruje się z Edge, ChatGPT z przeglądarkami i aplikacjami mobilnymi, a Perplexity pozwala na zapisywanie kontekstów wyszukiwań - dzięki czemu użytkownik może kontynuować rozmowę na innym urządzeniu.

Wyszukiwanie nie jest już liniowe, tylko ciągłe i rozproszone. Ludzie nie wracają do Google, by dokończyć zapytanie - oni kontynuują rozmowę tam, gdzie są. AI Search wpasowuje się w ten rytm, odpowiadając na potrzeby natychmiast, w kontekście, bez barier między platformami.To właśnie tu leży prawdziwa zmiana: użytkownik nie dostosowuje się już do wyszukiwarki. To wyszukiwarka dostosowuje się do użytkownika: jego stylu, tonu, emocji i miejsca, w którym akurat się znajduje.

Podsumowanie

Modele LLM uczą się na ogromnych zbiorach tekstów, przewidując kolejne słowa; to daje płynne, pomocne odpowiedzi, ale wprowadza ryzyko błędów i uprzedzeń. AI Search generuje wnioski, nie jedynie wskazuje linki, a browsing i cytowania częściowo to równoważą. Użytkownicy oczekują natychmiastowości, personalizacji i dialogu, dlatego wyszukiwanie staje się ciągłą rozmową, obecną na wielu platformach.

Źródła:

www.rellify.com/blog/evolution-of-search-engines

perplexity.ai/page/ai-search-engines-vs-tradition-eYTfUTD2Qxyjay76eBJE1w

boomcycle.com/blog/transforming-search-the-impact-of-ai-on-user-behavior/#

searchengineland.com/seo-guide-large-language-models-413227

Czytaj również:

- Jak działają zero-click searches i jakie są ich konsekwencje?

- Czy AI zastąpi Google?

- Czy GEO zastąpi SEO? Porównanie pozycjonowania stron i SEO w AI

FAQ - pytania i odpowiedzi

LLM to duże modele językowe uczone na ogromnych zbiorach tekstu. Rozumieją kontekst i potrafią tworzyć zwięzłe odpowiedzi w naturalnym języku. W AI Search pełnią rolę „silnika rozumienia”: interpretują intencję pytania, łączą fakty z różnych źródeł i syntetyzują wnioski. Dzięki nim wyszukiwarka zmienia się w rozmowę, która pomaga szybciej dotrzeć do sedna. Sprawnie parafrazują i są wielojęzyczne. Transformery dzielą tekst na tokeny i przetwarzają je równolegle, używając mechanizmu uwagi (attention), który wskazuje najważniejsze fragmenty kontekstu. W AI Search pozwala to modelowi uchwycić zależności między pytaniem, wynikami z sieci i historią rozmowy. Dzięki temu odpowiedź jest spójna, zrozumiała i dopasowana do bieżącej intencji użytkownika. Halucynacje to sytuacje, gdy model generuje pewnie brzmiące, lecz błędne informacje. By ich unikać, warto: zadawać precyzyjne pytania, wymagać podawania źródeł, porównywać kilka linków i w kluczowych tematach weryfikować dane poza AI. Pomaga też korzystanie z trybów z cytowaniami oraz doprecyzowanie kontekstu, np. zakresu dat lub kraju. Pomocne też pytania uzupełniające i zawężanie temat do celu. Wiele narzędzi AI Search pokazuje odnośniki do źródeł, z których budowana jest odpowiedź. To zwiększa przejrzystość i ułatwia weryfikację. Jednak jakość zależy od konkretnej platformy i pytania. Najlepszą praktyką jest kliknięcie w podane linki, sprawdzenie autora, daty oraz zgodności między streszczeniem a treścią. W zdrowiu i finansach błędna rada może mieć poważne skutki. AI Search bywa pomocne, ale modele mogą halucynować lub nie znać kontekstu medycznego i prawnego. Ryzyka to: nieaktualne dane, brak kwalifikacji, mylne uogólnienia. Zawsze weryfikuj w zaufanych źródłach i konsultuj się ze specjalistą. Traktuj wynik jako wstęp do decyzji, nie ostateczne zalecenie.Co to są LLM i jak wspierają AI Search?

Jak działa architektura transformerów w AI Search?

Czym są „halucynacje” modeli i jak ich unikać?

Czy AI Search podaje wiarygodne źródła odpowiedzi?

Jakie ryzyka niesie używanie AI Search w tematach zdrowia i finansów?

Poznaj historie sukcesów naszych klientów

Clutch.co to jedna z najbardziej wiarygodnych platform z opiniami na świecie!

Ponad 650 pozytywnych opinii w Google i 130 opinii na Clutch.co

Jesteśmy jedną z najlepiej i najczęściej ocenianych agencji marketingu internetowego w Polsce na największych platformach do ocen: Google i Clutch.co. Zobacz, nasze oceny i przekonaj się, że warto z nami współpracować.