Etyka, prywatność i zaufanie w AI Search

• Czy AI działa etycznie?

• Jak działają halucynacje?

• Jak działa prywatność użytkowników w AI Search?

• Jak działa kontrola i odpowiedzialność w AI Search?

• Jak działają regulacje AI w Polsce i Unii Europejskiej?

• Praktyczne zalecenia dla użytkowników AI Search

• Podsumowanie

• FAQ - pytania i odpowiedzi

Sztuczna inteligencja coraz częściej decyduje, co widzimy, czytamy i w co wierzymy. Ale czy możemy jej ufać? AI Search potrafi błyskawicznie analizować dane, jednak czasem tworzy „halucynacje” - przekonujące, lecz fałszywe informacje. W grę wchodzą też prywatność, odpowiedzialność i prawo. Gdzie kończy się wygoda, a zaczyna ryzyko? W tym rozdziale przyglądamy się etyce, prywatności i zaufaniu w AI Search.

Z tego rozdziału dowiesz się:

- Jaka jest etyka działania AI Search,

- Czym są halucynacje,

- Jak działa prywatność w AI Search,

- Czym jest AI Act,

- Jak działa Digital Service Act.

Czy AI działa etycznie?

Nie ma na to pytanie jednoznacznej odpowiedzi. Etyka w AI to codzienny dylemat: czy możemy ufać systemom, których decyzji nie rozumiemy? AI Search potrafi błyskawicznie analizować dane i rozumieć nasze pytania, ale często nie wiemy, dlaczego pokazuje właśnie te wyniki. To tzw. efekt czarnej skrzynki - brak przejrzystości, który rodzi niepewność.

Wyobraźmy sobie, że algorytm wybiera kandydatów do pracy albo rekomenduje leczenie. Jeśli jego decyzje są oparte na błędnych danych lub nieświadomych uprzedzeniach, skutki mogą być bardzo realne. I wtedy pojawia się pytanie: kto za to odpowiada - programista, firma, a może sama sztuczna inteligencja?

Paradoks polega na tym, że im bardziej AI staje się skomplikowana, tym chętniej jej ufamy. Bo działa szybko, skutecznie, bez emocji. Ale to właśnie emocje - nasza potrzeba zrozumienia i kontroli - są kluczem do etyki. Transparentność, możliwość sprawdzenia źródeł i świadome korzystanie z technologii to dziś nie luksus, a konieczność.

Zaufanie do AI nie powinno być ślepe. Trzeba je budować przez otwartość, odpowiedzialność i odwagę zadawania pytań: dlaczego system podjął taką decyzję? Bez tego nawet najbardziej inteligentna wyszukiwarka pozostanie tylko błyszczącą czarną skrzynką.

Czytaj również: „Jak korzystać z AI zgodnie z etyką i prawem?”.

Jak działają halucynacje?

Halucynacje AI to całkiem realny problem. W świecie AI Search oznaczają sytuację, w której system generuje informacje brzmiące przekonująco, ale... całkowicie zmyślone. Algorytm nie kłamie z premedytacją, dlatego nie warto go personifikować. Algorytm ufa swoim danym, nawet jeśli te dane są błędne.

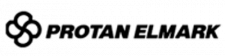

Dlaczego AI Search „halucynuje”? Powodów jest kilka:

- Po pierwsze - jakość danych treningowych. Modele uczą się na ogromnych zbiorach tekstów z internetu, a tam, jak wiadomo, obok rzetelnych źródeł jest też wiele nieprawdziwych informacji.

- Po drugie - presja generowania odpowiedzi. System nie znosi pustki, więc zamiast przyznać „nie wiem”, często uzupełnia luki własnymi przypuszczeniami.

- Po trzecie - brak pełnego kontekstu. Jeśli pytanie jest nieprecyzyjne, AI musi zgadywać, co użytkownik miał na myśli. I właśnie wtedy rodzą się halucynacje.

Powody halucynacji AI.

Czytaj również:

Jakie są konsekwencje halucynacji?

Konsekwencje w kontekście AI Search są poważne. Wystarczy, że użytkownik potraktuje fałszywą informację jako fakt i dalej ją powieli. W skali internetu taka pomyłka rozprzestrzenia się jak iskra. Pomyślmy o tematach wrażliwych - zdrowie, polityka, finanse, czyli tak zwane YMYL (”Your Money Your Life”). Jedno błędne zdanie w odpowiedzi wyszukiwarki może wpłynąć na decyzje tysięcy osób. AI Search, mimo swojej mocy, nie jest więc wyrocznią, tylko narzędziem, które wymaga nadzoru. Czytaj więcej o optymalizacji zgodnie z YMYL.

Dlatego coraz więcej firm i zespołów badawczych skupia się na strategiach minimalizowania tego ryzyka:

- Pierwsza linia obrony to dane treningowe - im czystsze, tym mniejsze ryzyko błędów. To oznacza selekcję źródeł, filtrowanie dezinformacji, a czasem nawet ręczne korygowanie przykładów, na których model się uczy. W tym sensie dane są jak dieta: jeśli karmisz system „śmieciowym” tekstem, nie możesz oczekiwać zdrowych wyników.

- Drugi filar to rola człowieka - paradoksalnie, im bardziej zaawansowana AI, tym ważniejszy jest czynnik ludzki. Eksperci nadzorują proces uczenia, testują odpowiedzi, wychwytują błędy, zanim trafią one do użytkownika. W niektórych firmach funkcjonują nawet tzw. red teams - zespoły, które celowo „prowokują” system, by sprawdzić jego odporność na błędne wnioski. To jak crash testy dla inteligentnych modeli.

- Trzeci element to technologia sama w sobie, czyli sposoby uczenia AI, które zwiększają dokładność odpowiedzi - jedną z najskuteczniejszych metod jest Retrieval Augmented Generation (RAG), czyli połączenie klasycznego wyszukiwania informacji z generatywnym modelem językowym. Zamiast wymyślać fakty z pamięci, system najpierw przeszukuje wiarygodne źródła (np. bazy wiedzy, artykuły naukowe), a dopiero potem buduje odpowiedź. Dzięki temu ryzyko halucynacji maleje.

Ale nawet najlepszy system nie zastąpi zdrowego rozsądku. Tu wkracza najważniejsza zasada użytkownika: weryfikacja faktów. AI może być pomocnikiem, ale nie autorytetem absolutnym. Warto sprawdzać źródła, porównywać odpowiedzi i nie brać wszystkiego za dobrą monetę. Krytyczne myślenie to dziś nie tyle opcja, co konieczność - zwłaszcza w epoce, gdy każdy może publikować, a algorytmy mogą się mylić.

Czytaj również:

Jak działa prywatność użytkowników w AI Search?

Prywatność w kontekście AI Search to coś więcej niż tylko historia wyszukiwania. Systemy oparte na sztucznej inteligencji zbierają ogromne ilości informacji - od lokalizacji i preferencji, po ton zapytań i schematy myślenia. Każde słowo, które wpisujemy w okno wyszukiwania, jest analizowane.

AI Privacy oznacza więc ochronę danych osobowych i wrażliwych - tych, które są zbierane, używane, udostępniane lub przechowywane przez algorytmy. Problem w tym, że w świecie IoT dane powstają wszędzie: smartwatch śledzi puls, auto zapisuje trasę, aplikacja pogodowa zna naszą lokalizację co do metra. AI Search może te elementy połączyć, tworząc niezwykle szczegółowy obraz użytkownika. A to już nie personalizacja, tylko wgląd w prywatne życie. Czytaj więcej o Internet of Things.

Jakie są wyzwania i ryzyka w zakresie prywatności w AI Search?

Największym wyzwaniem jest sposób, w jaki te dane są gromadzone i przetwarzane. Często bez wyraźnej zgody, czasem nawet bez wiedzy użytkownika. Zdarza się, że akceptujemy regulaminy, które de facto pozwalają na nieograniczone wykorzystanie informacji w celach marketingowych, analitycznych czy treningowych.

Ryzyka prywatności w AI Search można streścić w trzech słowach: brak kontroli, wyciek, nadzór.

- Brak zgody - użytkownicy rzadko mają realny wpływ na to, jak ich dane są wykorzystywane. Systemy często działają w tle, gromadząc informacje „na wszelki wypadek”.

- Wyciek danych (Data Leakage) - każde połączenie z serwerem, każde logowanie to potencjalne źródło ryzyka. Wystarczy błąd w zabezpieczeniach, by prywatne zapytania stały się publiczne.

- Nadzór i tendencyjność - sztuczna inteligencja, analizując zachowania użytkowników, może nie tylko przewidywać decyzje, ale też je kształtować. Wyszukiwarka wie, co chcesz zobaczyć - i pokazuje to, zanim sam o tym pomyślisz.

Ryzyka prywatności AI Search.

Tradycyjne zasady prywatności, które przez lata stanowiły fundament bezpieczeństwa danych, dziś są wystawione na próbę. Ograniczenie zbierania (collection limitation) - brzmi dobrze na papierze, ale w praktyce systemy AI potrzebują ogromnych ilości danych do uczenia się. Często więc zbierają wszystko, co mogą, licząc, że „kiedyś się przyda”.

Określenie celu (purpose specification) zakłada, że dane są używane tylko w konkretnym kontekście. Ale granice tych celów rozmywają się, gdy jeden projekt badawczy płynnie przechodzi w inny.

Wreszcie, ograniczenie użycia (use limitation), czyli zakaz wykorzystywania danych do nowych celów bez zgody - bywa ignorowane, bo dane raz wprowadzone do modelu trudno później wycofać.

Jak działa kontrola i odpowiedzialność w AI Search?

Kontrola i odpowiedzialność w świecie AI Search to temat bardziej złożony, niż mogłoby się wydawać. Bo jeśli system generuje tekst, odpowiada na pytania, tworzy obrazy czy rekomenduje treści - to kto właściwie jest jego autorem? I kto ponosi odpowiedzialność, gdy coś pójdzie nie tak?

Na początek warto zaznaczyć, że twórcy i dostawcy modeli AI nie mogą chować się za technologiczną zasłoną. Mają konkretne obowiązki - prawne, etyczne i społeczne. Deweloper AI powinien nie tylko stworzyć skuteczny system, ale też zadbać o jego zgodność z przepisami, w tym RODO i regulacjami unijnymi dotyczącymi sztucznej inteligencji (AI Act). To oznacza m.in. przejrzystość procesów decyzyjnych i możliwość audytu danych. Systemy AI muszą być inspectable, czyli otwarte na kontrolę: zarówno wewnętrzną, jak i zewnętrzną. Użytkownik ma prawo wiedzieć, skąd pochodzą dane, jak zostały przetworzone i dlaczego system udzielił konkretnej odpowiedzi.

Sprawdź także:

Czym jest możliwość odwołania w AI Search?

Równie ważna jest możliwość odwołania - decyzje podejmowane przez AI nie mogą być ostateczne. Jeśli sztuczna inteligencja zadecyduje o czymś, co ma wpływ na człowieka (np. odmówi kredytu, oceni wiarygodność kandydata, czy zinterpretuje dane w sposób szkodliwy), użytkownik powinien mieć prawo do interwencji. To coś w rodzaju cyfrowego prawa do obrony - mechanizmu, który przywraca człowieka do centrum decyzji.

Jak działa odpowiedzialność za treści z AI?

Nie można też zapominać o odpowiedzialności za treści generowane przez AI. Modele językowe potrafią tworzyć wiarygodne, lecz nieprawdziwe informacje, powielać błędy lub nieświadomie naruszać prawa autorskie. W takich sytuacjach winy nie można zrzucić na „system”. Odpowiedzialność spoczywa na jego twórcach, bo to oni projektują zasady działania, kontrolują dane treningowe i ustalają, jak AI interpretuje zapytania.

Czym jest prymat ludzkiego autorstwa?

W Polsce i całej Unii Europejskiej obowiązuje zasada prymatu ludzkiego autorstwa. Oznacza to, że prawo autorskie chroni wyłącznie utwory stworzone przez człowieka, nie przez maszynę. Jeśli więc AI wygeneruje tekst, grafikę lub muzykę bez ludzkiego udziału twórczego, taki „utwór” nie podlega ochronie prawnoautorskiej. Chodzi o zachowanie równowagi - by nie doszło do sytuacji, w której algorytmy stają się formalnymi „autorami”.

Jak działa twórczość wspomagana w AI?

Ciekawsza jest jednak sytuacja twórczości wspomaganej przez AI. Jeśli użytkownik AI Search wpływa na kształt treści - formułuje zapytania, redaguje, nadaje ton - może być uznany za autora, o ile jego wkład ma twórczy charakter. To tak, jakby AI była współpracownikiem, który podsuwa pomysły, ale to człowiek ostatecznie decyduje o efekcie. W praktyce granica jest cienka, a sądy dopiero zaczynają ją definiować.

Jak działa trening AI Search na cudzych danych?

Nie można też pominąć kwestii treningu AI Search na cudzych danych. To jeden z najbardziej kontrowersyjnych tematów ostatnich lat. Modele językowe uczą się na milionach tekstów - książkach, artykułach, stronach internetowych - często bez zgody autorów. To rodzi pytania o legalność i etykę. Czy fakt, że dane są publicznie dostępne, oznacza, że można je dowolnie wykorzystywać do trenowania modeli? Prawo unijne sugeruje, że nie i coraz częściej wymaga, by twórcy AI ujawniali źródła danych i respektowali prawa autorskie nawet w procesach uczenia maszynowego.

Kwestie problemowe z zakresu kontroli i odpowiedzialności AI.

Czytaj także:

Jak działają regulacje AI w Polsce i Unii Europejskiej?

Na terenie Unii Europejskiej mamy do czynienia z dwoma głównymi rozwiązaniami prawnymi dotyczącymi AI: AI Act i Digital Service Act. Sprawdźmy, jak działa każde z nich.

AI Act

AI Act to pierwszy w historii tak kompleksowy akt prawny dotyczący sztucznej inteligencji, przyjęty przez Unię Europejską w 2024 roku. Jego celem jest stworzenie ram dla działania AI, tak, aby była wykorzystywana etycznie, bezpiecznie i z poszanowaniem praw człowieka. W praktyce chodzi o to, by innowacje nie rozwijały się kosztem przejrzystości i bezpieczeństwa użytkowników. AI Act wprowadza więc zestaw reguł, które mają pomóc w zrównoważeniu postępu technologicznego z odpowiedzialnością społeczną.

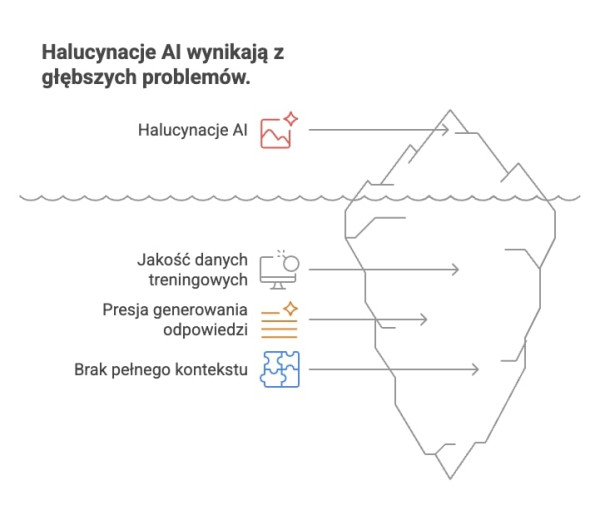

Istotnym elementem regulacji jest podejście oparte na ryzyku (risk-based approach). Systemy AI zostały podzielone na kategorie w zależności od potencjalnego wpływu na życie i prawa ludzi:

- Ryzyko niedopuszczalne (unacceptable risk) - obejmuje praktyki zakazane, takie jak manipulacja poznawcza, nadzór biometryczny w czasie rzeczywistym czy systemy oceny społecznej (tzw. social scoring). Te formy AI są wprost zabronione, ponieważ zagrażają godności i wolności jednostki.

- Wysokie ryzyko (high risk) - dotyczy systemów stosowanych w kluczowych obszarach: medycynie, edukacji, finansach, infrastrukturze krytycznej czy rekrutacji. Twórcy takich systemów muszą spełnić surowe wymogi dotyczące testowania, nadzoru i jakości danych. Każdy taki model musi mieć możliwość bycia poddanym audytowi, a jego decyzje powinny być możliwe do wyjaśnienia.

- Ograniczone i minimalne ryzyko - obejmuje aplikacje konsumenckie, np. chatboty czy rekomendacje zakupowe. Choć tu ryzyko jest mniejsze, przepisy wciąż wymagają informowania użytkownika, że wchodzi w interakcję ze sztuczną inteligencją.

Stopnie ryzyka w AI Act.

AI Act nakłada także obowiązki w zakresie transparentności. Użytkownicy mają prawo wiedzieć, kiedy komunikują się z AI, jakie dane są przetwarzane i w jakim celu. Wprowadza się też wymóg publikowania tzw. AI cards: krótkich opisów technicznych, które ujawniają funkcje, ograniczenia i potencjalne ryzyka modeli.

Osobny rozdział regulacji dotyczy modeli ogólnego przeznaczenia (GPAI, General Purpose AI), czyli systemów, które można wykorzystać w wielu dziedzinach, od edukacji po medycynę. Deweloperzy GPAI mają obowiązek ujawniać źródła danych treningowych, dbać o ich jakość i ograniczać ryzyko halucynacji czy dezinformacji. W praktyce to oznacza, że każda firma korzystająca z dużych modeli językowych (np. OpenAI, Google, Anthropic) musi zapewnić możliwość inspekcji i raportowania użytych danych.

Digital Service Act

Równolegle do AI Act, funkcjonuje Digital Services Act (DSA), regulacja skupiona na odpowiedzialności platform internetowych. Jej celem jest zwiększenie transparentności i bezpieczeństwa w przestrzeni cyfrowej, zwłaszcza w kontekście dezinformacji i treści generowanych przez algorytmy. DSA wymaga od dużych platform (tzw. VLOP, Very Large Online Platforms) publikowania raportów o sposobie moderowania treści, metodach rekomendacji oraz źródłach finansowania reklam. To ważne również dla AI Search, które coraz częściej łączy funkcje wyszukiwarki z generowaniem odpowiedzi.

Powiązanie z RODO (GDPR) jest tu bardzo istotne. AI Act i DSA wzajemnie się uzupełniają: RODO chroni dane osobowe, a AI Act reguluje sposób, w jaki są przetwarzane przez algorytmy. Oznacza to, że każdy system AI działający w UE musi spełniać podwójne standardy: ochrony danych i etycznej przejrzystości. W efekcie powstaje spójny ekosystem prawny, który stawia użytkownika w centrum, nie jako obiekt analizy, ale jako podmiot, który ma prawo do wiedzy, kontroli i sprzeciwu.

|

Regulacja |

Zakres działania |

Kluczowe obowiązki i cele |

Znaczenie dla użytkowników i AI Search |

|

AI Act |

Kompleksowa regulacja dotycząca sztucznej inteligencji w Unii Europejskiej |

|

|

|

Digital Service Act (DSA) |

Regulacja dotycząca dużych platform internetowych (tzw. VLOP – Very Large Online Platforms) |

|

|

|

RODO (GDPR) |

Unijne rozporządzenie o ochronie danych osobowych |

|

|

W praktyce te regulacje nie są hamulcem rozwoju, lecz próbą nadania mu ludzkiego wymiaru. AI może być szybka, inteligentna i skuteczna, ale tylko wtedy, gdy działa w granicach zaufania, jakie wyznacza prawo.

Praktyczne zalecenia dla użytkowników AI Search

Transparentność i prawo do wyjaśnienia to fundament świadomego korzystania z AI Search. Użytkownik ma prawo wiedzieć, jak powstała dana odpowiedź, na jakich źródłach się opiera i czy system dokonał jakichkolwiek uproszczeń. Jeśli decyzje lub rekomendacje wynikają wyłącznie z działania algorytmu, należy je kwestionować. Maszyna nie jest nieomylna - opiera się na danych, które mogą być niepełne, stronnicze lub przestarzałe.

W przyszłości coraz większą rolę odegra tzw. AI explainability, czyli zdolność systemów do tłumaczenia swoich procesów decyzyjnych. Modele będą mogły nie tylko wskazać wynik, ale też opisać drogę, która do niego prowadziła: jakie źródła uwzględniły, które pominęły i dlaczego. Rozwijane są metody testowania algorytmów pod kątem stronniczości, co pozwoli sprawdzić, czy nie faworyzują one określonych opinii, grup czy źródeł.

Sprawdź także:

Jakie są zasady etycznego stosowania AI Search?

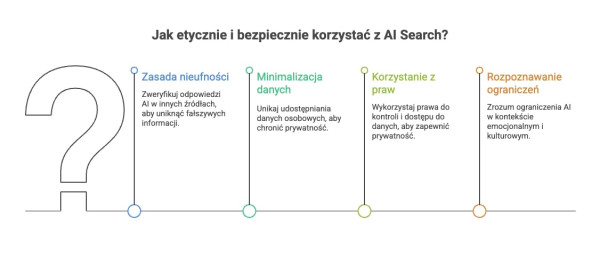

Aby korzystać z AI Search etycznie i bezpiecznie, warto trzymać się kilku prostych, ale ważnych zasad:

- Zasada nieufności - chodzi o zdrowy sceptycyzm. Zanim uwierzysz w odpowiedź AI, zweryfikuj ją w innych źródłach. Nawet najlepszy model może „halucynować”, czyli generować informacje brzmiące wiarygodnie, lecz całkowicie fałszywe. Nie traktuj więc wyników AI Search jak ostatecznej prawdy, raczej jak punkt wyjścia do dalszego sprawdzenia.

- Minimalizacja danych - im mniej informacji o sobie udostępniasz, tym lepiej. Unikaj wpisywania danych osobowych, medycznych czy finansowych. Nie wiesz, gdzie te dane trafią i jak zostaną użyte. AI Search działa szybciej i skuteczniej, gdy zna użytkownika, ale to nie oznacza, że trzeba dzielić się wszystkim. W praktyce: wyłącz historię zapytań, nie loguj się tam, gdzie nie musisz, i regularnie czyść pamięć wyszukiwania.

- Korzystanie ze swoich praw - pamiętaj, że w Europie obowiązuje prawo do sprzeciwu, dostępu i kontroli nad danymi. Możesz zażądać informacji o tym, jakie dane o tobie przetwarza system, a nawet poprosić o ich usunięcie. Coraz więcej platform oferuje też możliwość cofnięcia zgody na personalizację wyników. Warto z tego korzystać, zwłaszcza gdy chodzi o prywatność i bezpieczeństwo.

- Rozpoznawanie ograniczeń - AI Search jest dobra w analizie danych, lecz nie rozumie kontekstu emocjonalnego, ironii ani subtelnych niuansów kulturowych. Dlatego zawsze potrzebuje czujnego ludzkiego oka. Warto pamiętać, że każda odpowiedź AI to efekt matematycznej kalkulacji, nie empatii ani doświadczenia.

Dobre praktyki etycznego stosowania AI.

Te zasady można potraktować jak swoisty „kodeks użytkownika AI”. AI Search może być niezwykle pomocna, pod warunkiem że nie oddajemy jej bezkrytycznie sterów. Weryfikacja, ostrożność i zdrowa ciekawość to najlepsze narzędzia, jakie mamy.

Podsumowanie

AI Search to potężne narzędzie, ale jego siła idzie w parze z odpowiedzialnością. Zaufanie, etyka i prywatność nie są dodatkiem do technologii, są jej fundamentem. Świadome korzystanie z AI oznacza krytyczne myślenie, kontrolę nad danymi i prawo do zrozumienia decyzji algorytmów. AI Search zmienia sposób, w jaki szukamy informacji, ale wymaga od nas większej odpowiedzialności. Weryfikuj fakty, chroń swoje dane i pamiętaj, że nawet najbardziej zaawansowany algorytm potrzebuje ludzkiego nadzoru. To człowiek powinien pozostać autorem decyzji, nie maszyna.

Źródła:

digital-strategy.ec.europa.eu/en/policies/regulatory-framework-ai

trafficwatchdog.pl/en/blog/hwwk9tbje204okjcza596h7q/copyright-in-ai-generated-images-the-state-of-play-in-2025

drmalinowski.edu.pl/posts/3912-sztuczna-inteligencja-a-prawo-autorskie-w-polsce

ovic.vic.gov.au/privacy/resources-for-organisations/artificial-intelligence-and-privacy-issues-and-challenges/

Czytaj również:

- Jak dbać o bezpieczeństwo danych klientów?

- Generatywna AI w marketingu — co musisz o niej wiedzieć?

- Za kulisami sztucznej inteligencji — jak naprawdę działają algorytmy AI?

FAQ - pytania i odpowiedzi

Halucynacje w AI Search to sytuacje, w których system generuje informacje brzmiące wiarygodnie, ale niezgodne z faktami. Dzieje się tak, gdy algorytm wypełnia luki w danych własnymi przypuszczeniami zamiast przyznać, że „nie wie”. To częsty efekt uczenia się na niepełnych lub błędnych źródłach, dlatego warto zawsze weryfikować odpowiedzi AI w innych miejscach. AI Search analizuje ogromne ilości danych, by dopasować wyniki do użytkownika. W tym celu może gromadzić informacje o lokalizacji, historii wyszukiwania czy preferencjach. Choć pomaga to w personalizacji wyników, rodzi też ryzyko nadużyć i utraty kontroli nad danymi. Dlatego tak ważna jest transparentność działania i możliwość decydowania, co udostępniamy. Bezpieczeństwo danych zależy od polityki konkretnej platformy i sposobu jej zabezpieczenia. Większość usług stosuje szyfrowanie i środki ochrony prywatności, ale żaden system nie jest całkowicie wolny od ryzyka wycieku. Użytkownik może zwiększyć bezpieczeństwo, ograniczając ilość udostępnianych informacji, regularnie czyszcząc historię i kontrolując ustawienia prywatności. Formalnie odpowiedzialność ponoszą twórcy i dostawcy systemów AI, bo to oni projektują algorytmy, decydują o źródłach danych i zasadach działania. Jednak użytkownik również ma swoją rolę - powinien korzystać z AI z rozwagą i sprawdzać wyniki. W Unii Europejskiej wprowadza się przepisy (AI Act), które jasno określą obowiązki i zakres odpowiedzialności firm tworzących systemy sztucznej inteligencji. Najważniejszym aktem jest AI Act - pierwsze kompleksowe prawo regulujące rozwój i stosowanie sztucznej inteligencji w Europie. Wprowadza ono zasady transparentności, podział systemów według poziomu ryzyka i obowiązki dla twórców AI. Drugim kluczowym dokumentem jest Digital Services Act (DSA), który dotyczy odpowiedzialności platform internetowych i walki z dezinformacją. Oba akty współdziałają z RODO, chroniąc dane i prawa użytkowników.Co to są „halucynacje” w AI Search?

Jak AI Search wpływa na prywatność użytkowników?

Czy moje dane są bezpieczne podczas korzystania z AI Search?

Kto odpowiada za błędy popełnione przez AI Search?

Jakie regulacje prawne dotyczą AI Search w Unii Europejskiej?

Poznaj historie sukcesów naszych klientów

Clutch.co to jedna z najbardziej wiarygodnych platform z opiniami na świecie!

Ponad 650 pozytywnych opinii w Google i 130 opinii na Clutch.co

Jesteśmy jedną z najlepiej i najczęściej ocenianych agencji marketingu internetowego w Polsce na największych platformach do ocen: Google i Clutch.co. Zobacz, nasze oceny i przekonaj się, że warto z nami współpracować.