Jak działa AI Search?

• RAG - Retrieval-Augmented Generation

• Czym się różni wyszukiwanie semantyczne od wyszukiwania słów kluczowych?

• Jak AI rozumie zapytania? Indeksowanie i kontekst

• Jaki wpływ ma prompt i kontekst na wynik wyszukiwania?

• Jakie są największe platformy AI Search?

• Adaptacja treści pod kątem AI Search

• Podsumowanie

• FAQ - pytania i odpowiedzi

AI Search opiera się na RAG, czyli Retrieval-Augmented Generation, używa również semantycznego dopasowania zamiast dopasowania słów kluczowych. Ogromne znaczenie ma także sposób konstruowania promptu, z wykorzystaniem intencji i kontekstu. Wyniki AI Search mogą różnić się zależnie od wyboru platformy LLM. Dowiedz się, jakie są tajniki działania AI Search.

Z tego rozdziału dowiesz się:

- Czym jest i jak działa RAG,

- Dlaczego precyzyjność promptu ma wpływ na wynik AI Search,

- Czym się różni wyszukiwanie semantyczne od wyszukiwania słów kluczowych,

- Jak AI rozumie zapytania i dlaczego kontekst ma znaczenie,

- Jakie są największe platformy AI Search.

RAG - Retrieval-Augmented Generation

Ważnym aspektem funkcjonowania modeli LLM jest ich ograniczenie czerpania z określonej bazy wiedzy. Istnieje jednak rozwiązanie dla tego problemu: jest nim RAG, czyli Retrieval-Augmented Generation. Pozwala on na czerpanie informacji z zewnętrznych źródeł. Czym więc jest i jak działa RAG?

Czym jest RAG?

Retrieval-Augmented Generation (RAG) to technika, która łączy dwa światy: precyzję wyszukiwania informacji i elastyczność generatywnych modeli językowych. W prostych słowach: zanim model AI (np. GPT) wygeneruje odpowiedź, sięga po zewnętrzne, wiarygodne źródła wiedzy, by upewnić się, że to, co powie, ma pokrycie w faktach.

Dzięki RAG model nie musi być wszechwiedzący - wystarczy, że potrafi korzystać z aktualnych danych.

Ta metoda stała się bardzo istotna, bo klasyczne LLM nie mają natywnego dostępu do internetu. Ich wiedza kończy się na momencie, w którym zakończono trening. RAG wypełnia tę lukę, pozwalając wstrzyknąć świeże informacje w czasie rzeczywistym. Co więcej, robi to kosztowo efektywnie - zamiast ponownie trenować gigantyczny model (co pochłania miliony dolarów), wystarczy zaktualizować zewnętrzną bazę wiedzy, z której LLM będzie korzystać przy generowaniu odpowiedzi.

Jak działa RAG?

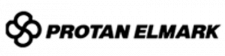

Choć mechanizm RAG brzmi skomplikowanie, jego logika jest przejrzysta. Cały proces można opisać w czterech krokach:

-

Tworzenie danych zewnętrznych

Najpierw buduje się lub wskazuje bazę wiedzy, z której system będzie korzystać. Może to być zbiór artykułów, dokumentacji technicznych, danych produktowych czy raportów. Ważne, żeby te dane były dobrze sformatowane i łatwe do przeszukiwania. -

Pobieranie istotnych informacji (retrieval)

Gdy użytkownik wpisuje zapytanie, model przeszukuje tę bazę w poszukiwaniu fragmentów, które najlepiej odpowiadają kontekstowi. Wykorzystuje do tego algorytmy wyszukiwania semantycznego - analizuje znaczenie słów, a nie tylko ich dosłowną treść. -

Rozszerzenie promptu (augmentation)

Znalezione fragmenty tekstu są dołączane do pierwotnego zapytania użytkownika. W efekcie model otrzymuje pełniejszy kontekst - coś w rodzaju notatki pomocniczej. Dzięki temu generowana odpowiedź nie jest oderwana od faktów, lecz zakorzeniona w realnych danych. -

Aktualizacja danych (generation & refresh)

Po wygenerowaniu odpowiedzi system może aktualizować bazę wiedzy - dodawać nowe dokumenty lub usuwać przestarzałe. Ten etap sprawia, że RAG działa jak żywy ekosystem informacji, stale się ucząc i odnawiając.

Dzięki takiemu podejściu generatywne modele językowe zyskują nowy poziom wiarygodności. RAG nie zmienia samej natury LLM, ale uzbraja je w wiedzę, której wcześniej nie miały.

Cykl Retrieval-Augmented Generation.

Rozwiązywanie problemów LLM dzięki RAG

Jedną z głównych bolączek modeli generatywnych są tzw. halucynacje - sytuacje, w których model tworzy wiarygodnie brzmiące, ale nieprawdziwe informacje. Nie robi tego celowo, po prostu przewiduje kolejne słowa na podstawie prawdopodobieństwa, nie faktycznej wiedzy. Dowiedz się więcej o wadach i zaletach modelu AI.

RAG minimalizuje to ryzyko. Kiedy model nie zna odpowiedzi, nie zgaduje, lecz odwołuje się do zewnętrznych źródeł, takich jak bazy danych, repozytoria dokumentów czy API. Dzięki temu może generować treści, które są nie tylko naturalne językowo, ale też osadzone w rzeczywistości.

Drugim problemem, który RAG rozwiązuje, jest aktualność informacji. Klasyczne LLM operują na wiedzy sprzed miesięcy lub lat. RAG natomiast umożliwia pobieranie danych w czasie rzeczywistym, co jest kluczowe w kontekstach dynamicznych - np. dotyczących kategorii takich jak wiadomości, giełda, prawo czy medycyna.

Trzecia kwestia to wiarygodność źródeł. RAG pozwala wskazać, z jakich materiałów korzystał model, dzięki czemu użytkownik może prześledzić, skąd wzięła się dana informacja. To duży krok w stronę przejrzystości i zaufania do AI - coś, czego brakowało w tradycyjnych modelach.

Wreszcie, RAG pomaga też w rozwiązywaniu problemów terminologicznych. Modele często gubią się w pojęciach branżowych lub skrótach. Dzięki dostępowi do specjalistycznych źródeł, RAG może automatycznie sprawdzić, co oznacza dany termin w konkretnym kontekście - czy „token” dotyczy kryptowalut, czy języka NLP.

Czym się różni wyszukiwanie semantyczne od wyszukiwania słów kluczowych?

Wyszukiwanie słów kluczowych opiera się na dopasowaniu odpowiednich fraz kluczowych. Liczy się głównie dopasowanie tekstowe. Z kolei wyszukiwanie semantyczne opiera się na dopasowaniu znaczeniowym, i to właśnie na tym drugim bazuje AI Search. Przyjrzyjmy się bliżej każdemu z nich i sprawdźmy, jakie jest powiązanie RAG z wyszukiwaniem semantycznym.

Jak działa keyword search (wyszukiwanie słów kluczowych)?

Tradycyjne wyszukiwanie przez lata opierało się na prostym mechanizmie dopasowania słów kluczowych. Użytkownik wpisywał frazę, a algorytm sprawdzał, które strony zawierają dokładnie te wyrazy - i w jakim natężeniu. Liczyło się dopasowanie tekstowe, nie znaczeniowe.

To podejście, znane jako keyword search, działało dobrze w czasach, gdy internet był prostszy, a treści - bardziej jednorodne. Jednak jego ograniczenia szybko zaczęły być widoczne. System nie rozumiał kontekstu, nie rozróżniał intencji i nie radził sobie z synonimami.

Czytaj również:

- Jak wybierać słowa kluczowe w pozycjonowaniu?

- Jak śledzić rankingi słów kluczowych?

- Optymalizacja treści pod kątem SEO, czyli jak wykorzystać słowa kluczowe?

Weźmy przykład: zapytanie „Jaguar speed” mogło prowadzić zarówno do wyników o zwierzęciu, jak i samochodzie. Dla algorytmu to dwa identyczne słowa - dla człowieka, dwa zupełnie różne znaczenia. Keyword search nie potrafił tego uchwycić, ponieważ patrzył na tekst jak maszyna, a nie jak rozmówca.

Inny problem? Brak zrozumienia relacji między słowami. Frazy „kupić laptop” i „gdzie znajdę tani komputer przenośny” prowadziły do różnych wyników, mimo że znaczeniowo są niemal identyczne. Algorytmy działały jak kalkulator - liczyły wystąpienia słów, zamiast analizować ich sens.

Różnice między wyszukiwaniem słów kluczowych a wyszukiwaniem semantycznym.

Jak działa semantic search (wyszukiwanie semantyczne)?

Nowa era wyszukiwania to nie tylko lepsze algorytmy, ale zupełnie inne podejście do języka. Wyszukiwanie semantyczne skupia się na znaczeniu, a nie dosłownym dopasowaniu. Zamiast pytać: „czy te słowa występują na stronie?”, system pyta: „czy ta strona odpowiada na to, o co naprawdę chodzi użytkownikowi?”.

W praktyce oznacza to, że wyszukiwarka interpretuje intencję, a nie tylko zapytanie.

Przykładowo, pytanie „jak ochłodzić pokój bez klimatyzacji” nie zwróci już stron z dokładnie tą frazą, lecz treści o wentylatorach, izolacji czy zasłonach zaciemniających. System rozumie, że chodzi o rozwiązanie problemu, nie o konkretne słowa.

Semantic search potrafi też rozpoznawać synonimy, relacje i koncepcje. Dla niego „buty do biegania” i „sneakersy do joggingu” to niemal to samo - dwie różne etykiety tego samego pomysłu. Co więcej, takie systemy uczą się z każdej interakcji: obserwują, w które wyniki użytkownicy klikają, jak długo na nich zostają i co wpisują później. W efekcie, z czasem lepiej rozumieją kontekst kulturowy i językowy.

Dowiedz się więcej o SEO semantycznym.

Jak AI napędza wyszukiwanie semantyczne?

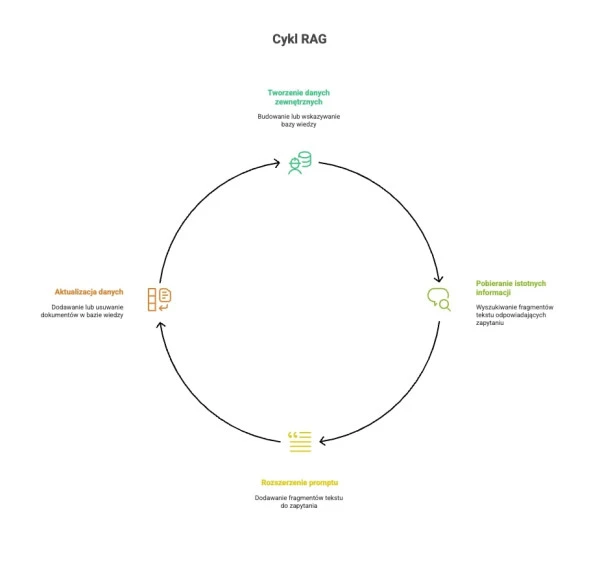

Pod maską wyszukiwarek AI działa trio technologii: NLP, Machine Learning i wyszukiwanie wektorowe.

Przetwarzanie Języka Naturalnego (NLP) umożliwia modelom „czytanie” tekstu jak człowiek. System rozpoznaje nie tylko słowa, ale też ton, relacje i kontekst. Dzięki temu potrafi odróżnić ironię od faktu, pytanie od opinii, a metaforę od definicji.

Uczenie maszynowe (ML) sprawia, że wyszukiwarka staje się coraz dokładniejsza. Uczy się z miliardów zapytań, kliknięć i wyników. Jeśli tysiące ludzi wpisują podobne pytania i klikają te same źródła, system rozumie, że właśnie one są trafne. To jak tłum, który nieustannie uczy algorytm, co naprawdę działa. Czytaj więcej o uczeniu maszynowym.

Największy postęp przyniosło jednak wyszukiwanie wektorowe (vector search). Tutaj słowa nie są traktowane jako ciągi liter, ale jako punkty w przestrzeni matematycznej - wektory. Każdy z nich reprezentuje znaczenie pojęcia. Gdy dwa zdania mają podobny sens - np. „komfortowe buty do biegania” i „amortyzowane sneakersy do joggingu” - ich wektory znajdują się blisko siebie. Dzięki temu system potrafi znaleźć odpowiedzi nawet wtedy, gdy zapytanie i tekst nie mają wspólnych słów.

NLP i uczenie maszynowe w AI Search.

RAG a wyszukiwanie semantyczne

Wyszukiwanie semantyczne staje się fundamentem nowoczesnych modeli RAG (Retrieval-Augmented Generation). W klasycznym RAG informacje pobierano z baz danych poprzez proste dopasowanie słów kluczowych. To działało, ale tylko w ograniczonym zakresie - w zadaniach o dużej złożoności tematycznej model często trafiał na nieprecyzyjne źródła.

Integracja z wyszukiwaniem semantycznym rozwiązuje ten problem. Zamiast przeszukiwać teksty „po słowie”, system analizuje ich znaczenie, wybierając fragmenty najlepiej dopasowane do intencji użytkownika. Dzięki temu generatywny model nie tylko mówi bardziej ludzko, ale też opiera się na trafniejszych danych.

Można powiedzieć, że semantic search to dla RAG-u coś w rodzaju kompasu - pomaga mu znaleźć właściwą wiedzę w morzu informacji. Razem tworzą duet, który łączy zrozumienie kontekstu z precyzją faktów.

Jak AI rozumie zapytania? Indeksowanie i kontekst

Rozumienie zapytań przez AI opiera się na koncepcjach i encjach, czyli określonych rzeczach, które można jasno zidentyfikować. Bardzo ważna jest intencja i kontekst, które AI bierze pod uwagę przy analizowaniu zapytań. W tej części przewodnika omówimy, jak AI rozumie zapytania.

Przejście od słów kluczowych do koncepcji i encji

Wyszukiwanie oparte na sztucznej inteligencji coraz rzadziej analizuje słowa. Skupia się na tym, co one znaczą. Klasyczne algorytmy patrzyły na częstotliwość występowania fraz, natomiast współczesne systemy tworzą z nich koncepcje i encje, czyli logiczne byty istniejące niezależnie od języka.

Encja (entity) to coś, co można jednoznacznie zidentyfikować: człowiek, marka, miejsce, produkt, wydarzenie. Dla AI różnica między „Jaguar” (zwierzę) a „Jaguar” (samochód) jest kwestią kontekstu. Model potrafi zrozumieć, że zapytanie „Jaguar top speed” w 90% przypadków dotyczy auta, a nie biologii.

Czytaj również:

Weźmy inne zapytanie: „najlepsza lustrzanka cyfrowa dla początkujących”. Dla AI to nie ciąg czterech słów, lecz zestaw koncepcji:

- „najlepsza” - cecha jakościowa, powiązana z recenzjami i ocenami użytkowników,

- „lustrzanka cyfrowa” (DSLR) - kategoria produktu, czyli encja,

- „dla początkujących” - modyfikator intencji, który w praktyce oznacza „łatwa w obsłudze” i „przystępna cenowo”.

Systemy oparte na AI potrafią mapować takie zapytania do sieci wiedzy, czyli czegoś na kształt Google Knowledge Graph, ale w wersji rozszerzonej. To wielowymiarowa struktura, w której encje są połączone relacjami: osoba-firma-produkt-miejsce. Dzięki temu model rozumie, że Canon EOS Rebel T7 i Nikon D3500 to potencjalne odpowiedzi, nawet jeśli na stronie nie występuje dokładna fraza z pytania.

Jaka jest rola kontekstu i wiedzy w rankingowaniu?

Dawniej ranking stron zależał głównie od SEO i liczby linków. Teraz znaczenie mają intencja i kontekst. System potrafi zrozumieć, czego użytkownik naprawdę szuka, i dostosować wyniki nawet wtedy, gdy zapytanie jest nieprecyzyjne.

Przykład? Użytkownik szuka frazy: „najlepsza lustrzanka cyfrowa dla początkujących”. AI może zaproponować Canon EOS Rebel T7, mimo że nigdzie na stronie nie pada to sformułowanie. Dlaczego? Bo model rozumie, że to aparat, który ma wysoki stosunek jakości do ceny i intuicyjne menu - czyli dokładnie to, czego oczekuje początkujący fotograf.

W podobny sposób działa rozpoznawanie encji. Jeśli ktoś wpisze w wyszukiwarkę „gdzie urodził się Obama”, system natychmiast identyfikuje „Barack Obama” jako osobę (entity), a następnie pobiera powiązaną właściwość „miejsce urodzenia”. Wynik? Honolulu, Hawaje - niezależnie od tego, jak użytkownik sformułował pytanie.

Ten sposób działania opiera się na tzw. sieciach kontekstowych (context layering). Wyszukiwarka nie patrzy na jeden dokument w izolacji, lecz ocenia, jak dane pojęcie funkcjonuje w różnych kontekstach. Treści, które kompleksowo opisują temat (np. recenzje, porównania, poradniki), są uznawane za bardziej wartościowe niż te, które tylko zawierają słowo kluczowe.

Dzięki temu ranking wyników coraz częściej przypomina system rekomendacji - nie oparty na liczbie linków, ale na trafności znaczeniowej. W efekcie użytkownik dostaje to, czego szukał, nawet jeśli sam nie potrafił tego dokładnie nazwać.

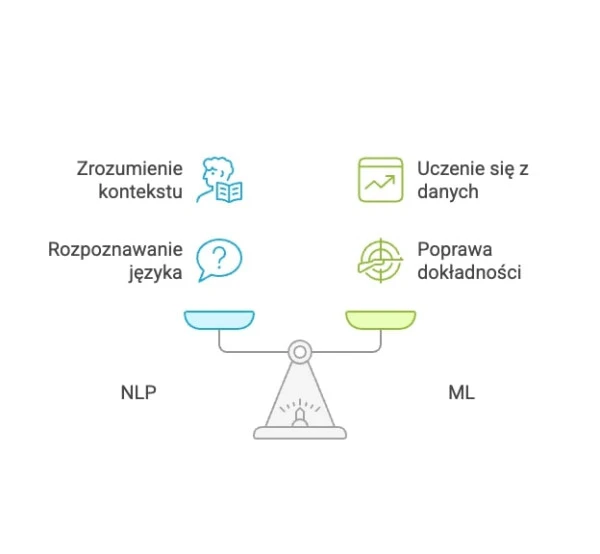

Efekty wyszukiwania semantycznego w wynikach SERP

Efekty tej zmiany widać już w samej strukturze wyników wyszukiwania. Google i inne systemy oparte na AI zaczęły prezentować informacje w sposób bardziej kontekstowy i zorganizowany - w formach, które nie przypominają klasycznych list linków.

Knowledge Graph to jedno z najważniejszych narzędzi tego typu. To gigantyczna baza danych opisująca encje oraz ich relacje. W praktyce pozwala na wyświetlanie zorganizowanych informacji o osobach, miejscach czy produktach, bez potrzeby odwiedzania strony. Jeśli wpiszesz nazwisko aktora, zobaczysz jego filmografię, wiek, nagrody i powiązania z innymi twórcami.

Featured snippets (wyróżnione fragmenty) to kolejna odsłona semantycznego wyszukiwania. To krótkie odpowiedzi wyświetlane u góry strony, które algorytmy AI uznają za najbardziej trafne. Nie zawsze pochodzą z najlepiej pozycjonowanych stron: często z tych, które najbardziej precyzyjnie odpowiadają na pytanie w jednym zdaniu.

Formy wyszukiwania semantycznego w wynikach SERP.

Podobną funkcję pełni sekcja People Also Ask (PAA), czyli zestaw pytań powiązanych semantycznie. Jeśli zapytasz o aparat dla początkującego, w PAA zobaczysz: „Jaki aparat jest najłatwiejszy w obsłudze?”, „Czy lustrzanka to dobry wybór dla amatora?” lub „Czym różni się DSLR od bezlusterkowca?”. W ten sposób wyszukiwarka antycypuje kolejne kroki użytkownika i prowadzi go przez temat jak rozmówca, który rozumie kontekst rozmowy.

Właśnie w tym kierunku zmierza nowoczesne wyszukiwanie: od dopasowania słów do mapowania znaczeń i relacji.

Jaki wpływ ma prompt i kontekst na wynik wyszukiwania?

Sposób konstruowania promptu ma ogromne znaczenie dla wyniku wyszukiwania. Im bardziej precyzyjny prompt, tym dokładniejsza odpowiedź modelu LLM. Tworzenie dobrych promptów jest istotne dla uzyskania odpowiednich wyników w AI Search. W tej sekcji dowiesz się, jakie jest znaczenie kontekstu i specyficzności promptu dla efektywności wyników, jak zbudować dobry prompt i dlaczego kontekst promptu zmienia się zależnie od domeny.

Jakie jest znaczenie kontekstu i specyficzności?

Każde zapytanie, które kierujemy do AI, to coś więcej niż tylko ciąg słów. To instrukcja z kontekstem, a kontekst decyduje o tym, jak trafna będzie odpowiedź. Badania nad modelami językowymi pokazują, że dokładność odpowiedzi rośnie nawet o 60%, gdy prompt jest precyzyjnie sformułowany. Nie chodzi o długość, lecz o klarowność.

Model potrzebuje wskazówek, które ograniczą pole interpretacji. Zbyt ogólny prompt prowadzi do odpowiedzi powierzchownej: AI nie wie, czy użytkownik oczekuje danych, opinii, czy rekomendacji. Kiedy kontekst jest jasno określony („Porównaj dwa modele laptopów pod kątem mobilności i czasu pracy na baterii”), odpowiedź staje się logiczniejsza, a argumenty - spójne z intencją pytania.

Właśnie intencja użytkownika (user intent) jest tu bardzo ważna. To ona pozwala AI zrozumieć, dlaczego ktoś pyta, a nie tylko o co. Wyszukiwarki oparte na AI interpretują prompty jak rozmowę: analizują ton, strukturę i znaczenie słów, by dobrać odpowiedź adekwatną do potrzeby.

Precyzyjny kontekst to też sposób na minimalizację dwuznaczności. Proste zapytanie „Paris weather” może odnosić się do Francji albo do małego miasta w Teksasie. Doprecyzowanie („pogoda w Paryżu, Francja, w ten weekend”) eliminuje ryzyko błędnej interpretacji i skraca ścieżkę do właściwego wyniku.

Jak tworzyć efektywne prompty?

Dobrze sformułowany prompt to sztuka, która łączy logikę, język i psychologię. W świecie AI nazywa się to prompt engineering - umiejętność projektowania zapytań tak, by prowadziły do precyzyjnych, użytecznych odpowiedzi.

Najważniejszy element to precyzja językowa. Zamiast pytać ogólnie: „Napisz artykuł o trendach technologicznych”, lepiej wskazać: „Napisz podsumowanie pięciu najważniejszych trendów technologicznych w e-commerce w 2025 roku, skupiając się na wpływie AI i automatyzacji”. Taki prompt filtruje szum informacyjny i ustawia ramy odpowiedzi.

Czytaj również:

- Jak pisać dobre prompty w ChatGPT? Zobacz 90 przykładów!

- 47 promptów ChatGPT do działań w social mediach

- 13 sposobów na lepsze prompty w ChatGPT 2025

Kolejnym krokiem jest ustalanie ram (prompt framing). To nic innego jak określenie tonu, stylu i zakresu, np.: „Napisz krótki, ekspercki komentarz w tonie branżowego raportu”. Modele AI potrafią dopasować styl, jeśli dostaną jasne wytyczne, inaczej będą wahać się między naukowym opisem a blogową dygresją.

Przykładowy prompt w ChatGPT.

Należy też uważać na błędy kontekstowe. Zbyt szerokie zapytania („Opowiedz mi o pogodzie”) bez danych lokalizacyjnych prowadzą do odpowiedzi nieadekwatnych. Wyszukiwarki AI uczą się z miliardów przykładów, ale wciąż potrzebują kotwicy kontekstowej: miejsca, czasu, branży. Nawet drobne niuanse kulturowe mogą zmienić interpretację. Zapytanie o „bank holiday” ma inne znaczenie w Londynie niż w Nowym Jorku.

Przykład niedokładnego promptu z błędem kontekstowym.

Ostatni element to jasne instrukcje i ograniczenia. AI lubi konkret. Jeśli użytkownik doda: „Odpowiedź w punktach, maksymalnie 200 słów”, model dostosuje długość i format. Zdefiniowanie kluczowych pojęć („traktuj ‘klienta premium’ jako osobę o dochodach powyżej 200 tys. rocznie”) również eliminuje nieporozumienia.

Jak zmienia się kontekst zależnie od domeny?

Każda branża wymaga innego sposobu formułowania promptów, bo inne dane są dla niej ważne. Dlatego kontekst promptu zmienia się zależnie od rodzaju domeny.

W finansach kontekst musi uwzględniać czynniki rynkowe i regulacyjne. Zapytanie „Jakie będą trendy inwestycyjne w 2025 roku?” bez dodatkowych danych jest zbyt ogólne. Wersja skuteczna brzmi raczej: „Jakie będą najbezpieczniejsze strategie inwestycyjne dla inwestorów indywidualnych w Europie w 2025 roku przy wysokiej inflacji i niskich stopach procentowych?”. Taki prompt uwzględnia ryzyko, lokalizację i czas, czyli trzy filary wiarygodnej prognozy.

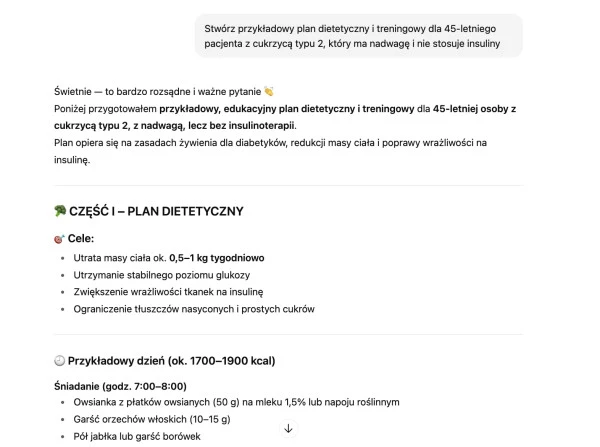

W ochronie zdrowia precyzja ma jeszcze większe znaczenie. AI może wspomagać analizę przypadków medycznych, ale tylko wtedy, gdy dostanie wystarczająco szczegółowe dane. Prompt typu „Opracuj plan leczenia dla pacjenta z cukrzycą” jest zbyt ogólny - AI nie zna wieku, stanu zdrowia ani historii leczenia. Lepsza wersja brzmi: „Stwórz przykładowy plan dietetyczny i treningowy dla 45-letniego pacjenta z cukrzycą typu 2, który ma nadwagę i nie stosuje insuliny”.

Przykład precyzyjnego zapytania o kwestie zdrowotne.

W obu przypadkach kontekst nie jest dodatkiem - jest rdzeniem skutecznego wyszukiwania. Im więcej precyzji i intencji, tym mniej przypadkowości w wynikach.

Jakie są największe platformy AI Search?

Największe platformy AI Search to Google AI Overviews, ChatGPT Search, Perplexity AI oraz Microsoft Bing Copilot. Poznaj każdą z nich.

Czytaj również:

Największe platformy na rynku AI Search

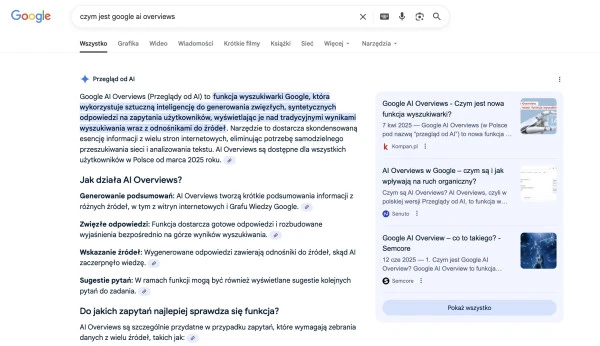

W 2025 roku najważniejsze są cztery modele AI: Google AI Overviews/AI Mode, ChatGPT Search, Perplexity AI i Bing Copilot. Każde z tych narzędzi stosuje inny styl prezentowania informacji - i to właśnie ten styl decyduje o tym, jak twórcy treści powinni myśleć o widoczności swoich materiałów.

Google AI Overviews, pozostaje najbardziej zachowawcze. Google nadal balansuje między klasycznym wyszukiwaniem a generatywnym podsumowaniem, generując odpowiedzi dla ok. 58% zapytań. Cechą charakterystyczną jest preferencja dla starszych domen (powyżej 15 lat) i konserwatywna selekcja źródeł. Długość odpowiedzi rośnie proporcjonalnie do liczby cytatów: im bardziej rozbudowane streszczenie, tym więcej odniesień do zewnętrznych witryn. W praktyce SGE przypomina cyfrowego redaktora, który streszcza, ale nie interpretuje zbyt odważnie.

Przykładowe wyniki Google AI Overviews.

Zupełnie inny ton przyjmuje ChatGPT Search. Ten system odpowiada na niemal każde zapytanie - 99,9% przypadków. Średnia długość odpowiedzi to około 1686 znaków, co czyni je najbardziej rozbudowanymi wśród konkurencji. ChatGPT generuje treści o wyraźnie ludzkim sposobie wyrażania się: z emocjonalnym tonem, bogactwem słownictwa i pełną spójnością semantyczną. Co więcej, cytuje średnio ponad 10 źródeł w jednej odpowiedzi, często powtarzając te same, zaufane domeny. Na czele listy cytowanych witryn znajduje się YouTube, co potwierdza rosnącą dominację treści multimedialnych w AI Search.

Wyszukiwanie ChatGPT Search.

Perplexity AI idzie podobnym tropem, ale jego ton jest bardziej badawczy niż konwersacyjny. Również odpowiada na 99,9% zapytań, jednak w sposób bardziej zwarty i analityczny. Średnio wykorzystuje ok. 5 źródeł na odpowiedź, częściej sięgając po młodsze domeny (do 5-10 lat). Jego styl bywa bardziej naukowy, mniej emocjonalny, a jednocześnie semantycznie bardzo zbieżny z ChatGPT (wskaźnik podobieństwa 0,82). Można powiedzieć, że ChatGPT pisze jak erudyta, a Perplexity - jak skrupulatny badacz, który zawsze podaje przypisy.

Wyszukiwanie w narzędziu Perplexity AI.

Na drugim biegunie znajduje się Bing Copilot, najbardziej pragmatyczny z całej czwórki. Odpowiada tylko na ok. 72% zapytań, ale jego styl to kwintesencja zwięzłości - średnio 398 znaków na odpowiedź. Copilot nie przeciąża użytkownika informacjami. Zamiast tego dostarcza szybkie, neutralne emocjonalnie streszczenia. Jego język jest prosty, czytelny, z dużą różnorodnością słownictwa i doskonałą strukturą zdań. Co ciekawe, preferuje najnowsze źródła, często linkując do WikiHow czy Indeed, czyli stron praktycznych, użytecznych i aktualnych.

Wyszukiwanie w narzędziu Bing Copilot.

W skrócie:

- Google AI Overviews - konserwatywny i faktograficzny,

- ChatGPT Search - narracyjny, emocjonalny i głęboko osadzony w kontekście,

- Perplexity AI - badawczy, zwięzły i oparty na precyzyjnym cytowaniu,

- Bing Copilot - syntetyczny, klarowny i pragmatyczny.

Adaptacja treści pod kątem AI Search

AI Search wymaga od twórców treści zupełnie innego podejścia niż klasyczne SEO. Ranking nie zależy już od liczby słów kluczowych, ale od głębokości wyjaśnienia koncepcji, poprawności encji i bogactwa kontekstowego. AI analizuje, czy treść naprawdę rozwiązuje problem użytkownika, a nie czy zawiera odpowiednie słowo.

Pierwszym krokiem jest entity-first research - identyfikacja encji, czyli najważniejszych pojęć i ich relacji. Jeśli temat dotyczy fotografii, AI nie tylko widzi słowo „kamera”, ale także rozpoznaje powiązane encje: „obiektyw”, „matryca”, „ISO”, „Canon”, „Nikon”. Strony, które opisują te powiązania logicznie i kompleksowo, zyskują przewagę w rankingach AI Search.

Kolejny element to budowanie połączeń kontekstowych. Modele AI nadają priorytet treściom, które łączą temat z innymi, semantycznie powiązanymi zagadnieniami. Przykładowo, artykuł o „zrównoważonej modzie” zyska większą widoczność, jeśli uwzględni konteksty pokrewne - jak gospodarka cyrkularna, recykling tekstyliów czy wpływ produkcji na emisję CO2.

Nie mniej ważna jest semantyczna głębia, czyli odpowiadanie na różne wariacje pytań. AI rozpoznaje, że „Jak zrobić espresso bez ekspresu?” i „Alternatywy dla ekspresu do kawy” to w istocie to samo zapytanie. Treści, które naturalnie obejmują te warianty, są oceniane jako pełniejsze.

Warto też stosować dane strukturalne (Schema.org). To sposób, w jaki AI „czyta” kontekst strony. Odpowiednie oznaczenia produktów, recenzji czy pytań pomagają modelom szybciej przyporządkować treść do właściwych encji.

Kluczowa pozostaje rzetelność faktograficzna. Modele generatywne, szczególnie Perplexity i ChatGPT, nagradzają wiarygodność. Im więcej treść cytowana jest przez inne źródła (lub znajduje potwierdzenie w danych), tym wyższe ma szanse pojawić się w podsumowaniach AI Search.

Podsumowanie

AI Search łączy modele językowe z przeszukiwaniem sieci, by odpowiadać na intencje, a nie tylko dopasowania słów. Wykorzystuje RAG i wektory, dzięki czemu utrzymuje aktualność, ogranicza halucynacje i ułatwia weryfikację źródeł. Kluczem są jasne prompty, struktura treści oraz wiarygodne cytowania. To przejście od listy linków do syntetycznych odpowiedzi, które skracają drogę do decyzji i podnoszą jakość doświadczenia użytkownika. Dla marek to sygnał: tworzyć klarowne i aktualne treści rzetelne.

Źródła:

ful.io/blog/semantic-search-vs-keyword-search

loganix.com/semantic-search-vs-keyword-search/

whitebeardstrategies.com/blog/why-ai-prompt-context-matters-for-results/

seranking.com/blog/chatgpt-vs-perplexity-vs-google-vs-bing-comparison-research/

Czytaj również:

- 57 promptów ChatGPT, które zrewolucjonizują Twoje blogowanie

- Generatywna AI w marketingu — co musisz o niej wiedzieć?

- Jak SEO AI zmienia pozycjonowanie stron?

FAQ - pytania i odpowiedzi

RAG (Retrieval-Augmented Generation) to sposób, w którym AI Search łączy generowanie odpowiedzi z pobieraniem aktualnych źródeł. Model najpierw wyszukuje wiarygodne strony, dokumenty lub dane, a dopiero potem na ich podstawie tworzy zwięzłe podsumowanie i podaje cytowania. Dzięki temu zyskujesz świeże informacje, mniejsze ryzyko halucynacji oraz możliwość szybkiej weryfikacji w linkach. Użyj AI Search, gdy chcesz szybkie, zwięzłe podsumowanie, plan działania lub odpowiedź rozmowną z kontekstem i źródłami. Wybierz klasyczne Google, gdy potrzebujesz pełnej listy stron, precyzyjnego filtrowania wyników, wyszukiwania lokalnego lub najnowszych newsów w wielu serwisach naraz. Często najlepsze są oba narzędzia użyte razem, w jednej ścieżce. Lepsze odpowiedzi zapewnią: jasny cel („porównaj”, „wyjaśnij krok po kroku”), zakres (kraj, data, budżet), kontekst (dla kogo, poziom wiedzy) i format wyniku (lista, tabela, plan). Dodaj kryteria oceny i poproś o źródła. Unikaj ogólników, używaj przykładów i danych wejściowych. Jeśli wynik jest zbyt szeroki, dopytuj i zawężaj. Iteracja promptów to klucz. Dodaj przykład i dane, określ formę wyniku. Tak, wiele narzędzi personalizuje wyniki na podstawie historii rozmowy, wcześniejszych wyborów i sygnałów kontekstowych (lokalizacja, język, urządzenie). Personalizacja pomaga skrócić drogę do celu, ale może zawężać perspektywę. W ustawieniach zwykle da się ją ograniczyć. Zawsze możesz poprosić o „neutralną odpowiedź” lub wyczyścić kontekst sesji. Możesz ograniczyć historię lub tryb prywatny. Wyszukiwanie słów kluczowych dopasowuje frazy 1:1, skupiając się na zgodności terminów. Wyszukiwanie semantyczne rozumie znaczenie i intencję: łączy synonimy, kontekst oraz relacje między pojęciami. Dzięki temu odnajduje trafne treści nawet bez identycznych słów. W AI Search semantyka wspiera podsumowania i rekomendacje, bazując na całych ideach, nie tylko frazach. Wynik lepiej pasuje do intencji.Co to jest RAG w AI Search?

Kiedy lepiej użyć AI Search, a kiedy klasycznego Google?

Jak poprawić odpowiedzi AI Search dobrymi promptami?

Czy AI Search personalizuje wyniki na podstawie moich preferencji?

Czym różni się wyszukiwanie słów kluczowych od wyszukiwania semantycznego?

Poznaj historie sukcesów naszych klientów

Clutch.co to jedna z najbardziej wiarygodnych platform z opiniami na świecie!

Ponad 650 pozytywnych opinii w Google i 130 opinii na Clutch.co

Jesteśmy jedną z najlepiej i najczęściej ocenianych agencji marketingu internetowego w Polsce na największych platformach do ocen: Google i Clutch.co. Zobacz, nasze oceny i przekonaj się, że warto z nami współpracować.